L’intelligence artificielle, source de désinformation

Une intelligence artificielle (IA) est un programme informatique capable de simuler certains traits de l’intelligence humaine, tels que la perception, la planification, le raisonnement, la prise de décision, ou encore la génération de contenus. Certaines IA génératives de textes – comme ChatGPT – sont désormais très connues du grand public. C’est également le cas pour des IA génératives d’images comme Midjourney ou DALL-E. Mais il existe désormais d’autres IA, capables par exemple de concevoir des vidéos ou de la musique.

Il est indéniable que l’émergence de ces outils constitue une véritable révolution. Ils peuvent être mise au service de l’industrie, de l’art, de la médecine et de nombreux autres secteurs d’activité. Dans le monde de l’entreprise, le rapport à l’acte créatif n’est plus le même. Les IA font également évoluer notre rapport à l’information. Par exemple, il est désormais très facile de poser une question à ChatGPT sur un sujet d’actualité. Que l’on souhaite savoir depuis quand Vladimir Poutine est au pouvoir en Russie, comment fonctionnent les institutions européennes ou encore quels sont les pays qui exportent le plus de sucre, on obtiendra une réponse.

Faut-il pour autant accorder toute confiance à ces nouveaux outils ? Certainement pas. Leur fonctionnement, on va le voir, ne permet pas de garantir la véracité des informations fournies. Explications.

Comment fonctionne une IA génératrice de contenu ?

Une intelligence artificielle génératrice de contenu s’appuie sur le machine learning (ou modèle d’apprentissage automatique) pour générer ce qui lui est demandé. Elle “apprend” à partir des données qui lui sont fournies. Plus ces données sont nombreuses et qualitatives, plus elle est donc en mesure de fournir des résultats pertinents et précis à l’internaute. Cela rend par exemple ChatGPT capable de produire des articles, des rapports, des courriels et de nombreux autres documents.

L’une des technologies employées pour développer et entraîner une IA est celle des GAN, ou réseaux antagonistes génératifs. Le principe est que deux réseaux s’occupent de créer des échantillons de données et évaluent dans le même temps leur pertinence. Il faut noter que dans ce cas, il revient à l’IA de déterminer si des informations sont justes ou fausses. La qualité des données fournies à l’IA détermine également la qualité des réponses de celle-ci.

Des erreurs manifestes

Il est indéniable que grâce aux évolutions récentes, les IA génératrices de contenus sont capables de prouesses. Au sein de nombreuses entreprises, elle a permis l’automatisation d’un grand nombre de taches. Certaines images générées par une IA – comme celle du pape en doudoune, devenue virale – paraissent plus vraies que nature au premier coup d’œil. Quant à ChatGPT et aux autres IA génératrices de texte, il faut leur reconnaître la capacité de répondre efficacement à plusieurs types de consignes : résumer ou reformuler un texte, donner très rapidement des informations sur un grand nombre de sujets, inventer des fictions etc.

Pour autant, ce haut niveau de performance ne peut masquer des erreurs encore nombreuses. Concernant les images générées par IA, on peut encore repérer dans de nombreux cas des détails prouvant que la photographie n’en est pas une : mains bizarres, couvre-chef incohérent, textes dénués de sens…

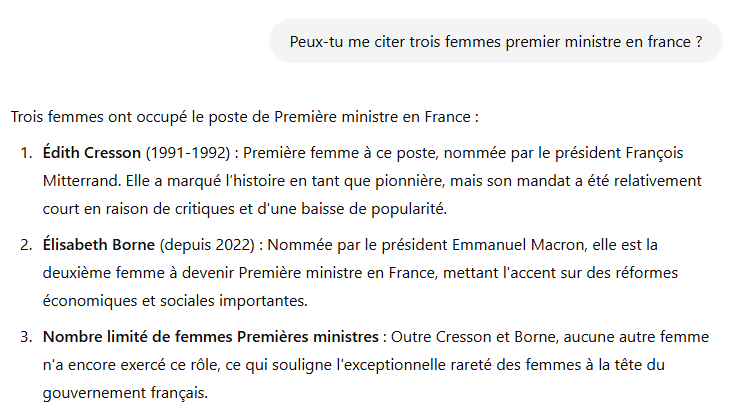

Si l’on s’en tient strictement aux IA génératrices de texte, elles ne sont pas non plus exemptes de défaut. Ainsi, selon Numérama, “ChatGPT ne doit pas être confondu avec un moteur de recherche ou une encyclopédie”. Il peut affirmer des choses fausses. L’article donne l’exemple d’une demande portant sur les premiers ministres français : le logiciel se trompe d’abord dans le sexe, quand on lui demande de citer “5 femmes qui ont été premier ministre en France”, en indiquant quatre hommes dans sa liste. Repris, il cite ensuite cinq noms de femmes… dont quatre n’ont jamais occupé ce poste à Matignon

Pas une seule fois le logiciel n’indique qu’il lui est impossible de répondre à la question qu’on lui pose : il n’y a à ce jour que deux femmes qui ont occupé la fonction demandée, Edith Cresson et Elisabeth Borne. Si l’on teste ChatGPT en 2024 avec une question similaire, la réponse est d’ailleurs encore incertaine…

Ce n’est pas là la seule erreur répertoriée pour ChatGPT, loin de là : le logiciel s’est déjà trompé sur d’autres personnalités publiques, et peut aller jusqu’à inventer des économistes ou créer des citations. Il faut donc bien admettre que sa compréhension des données qui lui parviennent est imparfaite. À ce jour, et même si on peut supposer que ces logiciels connaîtront des améliorations, on ne peut se reposer sur cette IA – ni sur aucune autre – pour s’informer correctement.

La qualité et le nombre de sources en question

La manière dont l’IA fonctionne pose question : elle récupère en effet des informations produites par des universitaires, des journalistes, des artistes… cela sans leur consentement et sans que ces personnes soient rémunérées. Elle exploite ensuite ces données sans que l’on sache de quelle manière.

Souvenons-nous par ailleurs que la qualité des réponses d’une IA dépend avant tout de celle des données fournies. Une expérience menée en mars 2016 par Microsoft pour créer un chatbot a ainsi tourné cours : “nourri” au moyen d’interactions sur Twitter, le chatbot s’est mis à produire des contenus racistes, misogynes et antisémites. Si cela constitue un exemple un peu extrême, il ne faut pas oublier qu’il n’est pas possible de demander à ChatGPT de donner ses sources (l’IA “condense” des données obtenues depuis de multiples sources… et toutes ne sont pas forcément fiables). Par ailleurs, pour parler de certains sujets, les IA disposent parfois de sources limitées, ce qui limite drastiquement la qualité des réponses fournies.

Quand l’IA facilite la production de désinformation

Tout cela constitue une véritable problématique : les IA génératives peuvent en effet contribuer au développement de la désinformation. Une étude a démontré que ChatGPT relaie dans 80 % des cas des informations fausses quand des questions orientées, par exemple complotistes, lui sont posées. L’absence de “barrière critique” pose problème, tout comme l’existence de données à caractère raciste ou misogyne dans lesquelles les IA peuvent piocher allègrement.

Il faut garder en tête enfin que l’existence des IA facilite la production de fausses informations. À titre d’exemple, évoquons le travail mené par les journalistes Thomas Huchon et Gabriel Holubowicz, auditionnés par une commission d’enquête du Sénat au sujet de l’IA. L’article rappelle qu’ils ont présenté à la commission “un clip entièrement réalisé par une IA et dans laquelle un double numérique du journaliste prend, tour à tour, la voix de Jean-Luc Mélenchon, de Gabriel Attal, de la chanteuse Angèle… ou encore celle du président de la commission d’enquête, le sénateur LR Dominique de Legge.” Troublant… et dangereux, car manipuler l’information devient facile et rapide. Les créateurs de ce clip ont expliqué que ce travail ne leur avait demandé qu’un quart d’heure…

Ce n’est pas sans raisons que la désinformation et la mésinformation sont devenues de véritables enjeux à échelle mondiale : l’IA générative donne en effet en la matière de nouveaux moyens de détourner la vérité et de fabriquer des mensonges crédibles à grande échelle.

Plus que jamais, il est donc indispensable de porter un regard critique sur les informations qui nous parviennent, de croiser les sources notamment face à certaines images d’apparence sensationnelle. Les IA ne sont pas de nouveaux outils “miracle” pour s’informer.

Nous partageons tous les mois des contenus

pour décrypter le monde des médias et de l’information

Podcast, guides, outils, infographies, évènements… nous partageons chaque mois, nos meilleures ressources pour vous mieux comprendre et appréhender les enjeux médiatiques et informationnels.